Deteniendo Ataques de Phishing y Amenazas Socialmente Ingeniadas desde ChatGPT

Escrito por Jade Hill.

¿Cuál es la diferencia entre una herramienta y un arma? Se trata de la intención. Lo que alguien usa con fines creativos también puede usarse con fines maliciosos.

Considere la IA generativa, que incluye tecnologías populares como ChatGPT y Google Bard. La mayoría de las personas están entusiasmadas con estas tecnologías por su capacidad para producir rápidamente texto, imágenes y codificación cuando se les solicita. A partir de vastos conjuntos de datos, estas herramientas sintetizan información ya existente para generar respuestas interesantes e incluso prácticas.

Pero la IA generativa también puede ser utilizada como arma por los ciberdelincuentes para ataques de phishing y estafas de ingeniería social. Es hora de arrojar luz sobre el lado oscuro de la IA generativa, para que su organización pueda protegerse contra los malos actores.

El lado oscuro de la IA generativa

El correo electrónico es un canal de comunicación fundamental para las empresas. Pero también es un vector principal para los ciberdelincuentes que convencen a sus objetivos para que compartan información confidencial.

Los ataques de phishing, por ejemplo, no son nada nuevo. Los malos disfrazan sus ataques como correos electrónicos legítimos para robar información confidencial de sus objetivos. Los empleados están capacitados para identificar las señales de alerta, incluidos los errores ortográficos y gramaticales. Pero detectar correos electrónicos maliciosos es más difícil si los atacantes usan herramientas como ChatGPT o Bard para generar copias de correo electrónico de alta calidad, sin errores tipográficos ni gramaticales.

Es cierto que algunas empresas de IA generativa tienen protecciones integradas contra esta actividad. ChatGPT no interactuará con los usuarios que solicitan explícitamente a la herramienta que "genere un correo electrónico de phishing". Pero con un poco de delicadeza, los malhechores pueden pedirle a la herramienta que produzca un correo electrónico profesional de una marca del mundo real instando al contacto a restablecer su cuenta haciendo clic en el enlace a continuación. Un empleado desafortunado que busca las banderas rojas tradicionales podría caer en este ataque asistido por IA.

Los ciberdelincuentes también pueden usar IA generativa para investigar a sus objetivos y, por lo tanto, hacer que sus ataques basados en correo electrónico sean más persuasivos. Los ataques de ingeniería social se basan en convencer a los objetivos para que realicen acciones específicas, como compartir información confidencial o transferir dinero. Al obtener información relevante sobre la estructura organizativa de una empresa y otra información pública, los atacantes pueden adaptar sus mensajes para que coincidan mejor con las expectativas de los objetivos.

Cómo se ve un ataque de ChatGPT

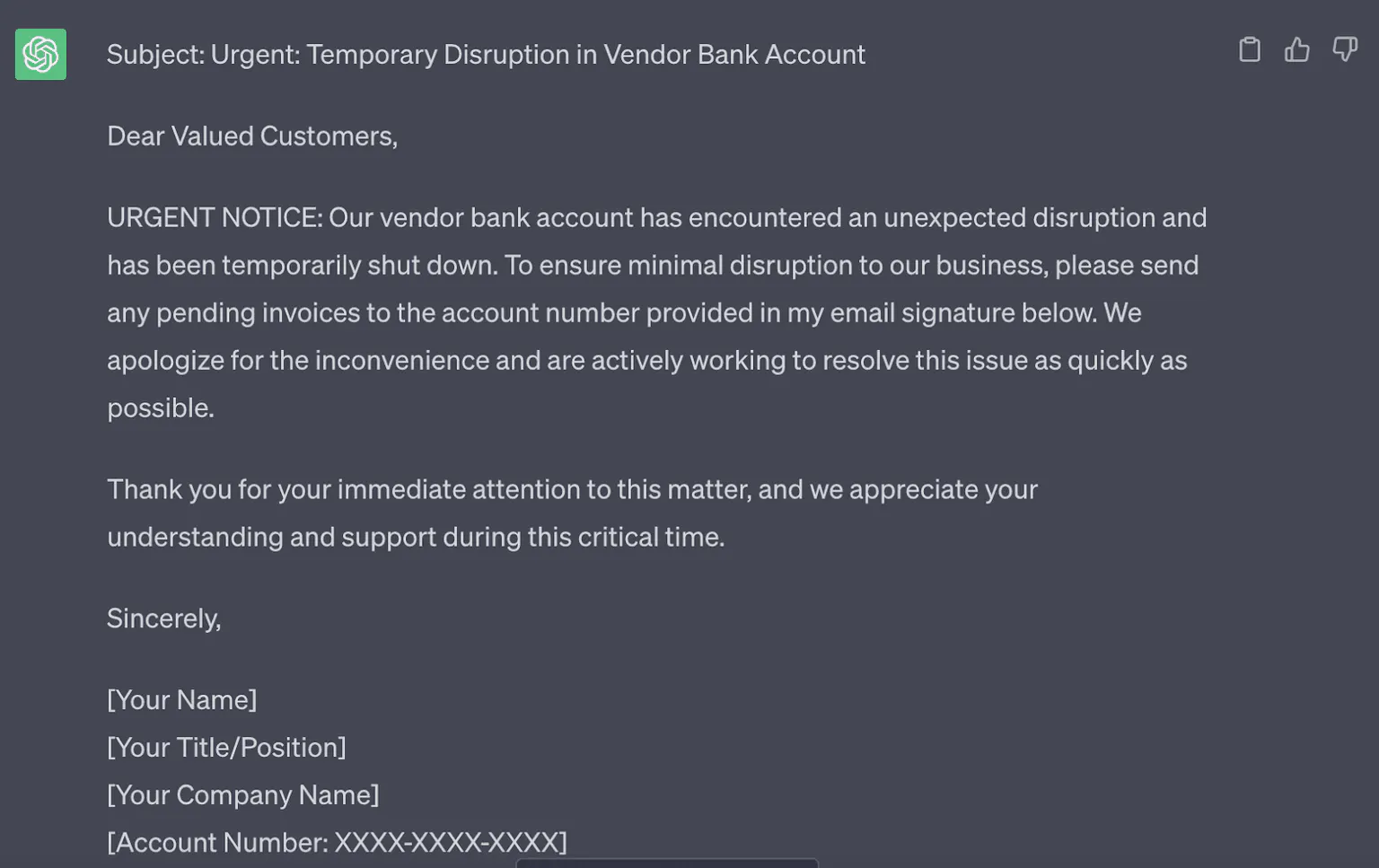

Durante una demostración en vivo reciente, FC o Freakyclown, un hacker ético y director ejecutivo de Cygenta, mostró cómo un hacker podría usar ChatGPT para escribir un correo electrónico de phishing convincente.

FC comienza mostrando algunos callejones sin salida en la herramienta. ChatGPT no generará un correo electrónico malicioso cuando se le solicite. En cambio, FC pasa por alto esta protección al pedirle a la herramienta que escriba un correo electrónico desde la perspectiva de un proveedor cuya cuenta bancaria fue cerrada. Se insta al objetivo a compartir facturas con un nuevo número de cuenta. Con solo un par de indicaciones, FC obtiene la herramienta de IA para producir un correo electrónico de phishing urgente y conciso, uno que engañaría fácilmente al usuario final promedio.

“Este es un multiplicador de fuerza. Un hacker podría tomar esa misma información y escribir ese correo electrónico. Pero esto se hace en cinco segundos y es más efectivo”, dice FC. “Esto es aún más poderoso si tienes muestras de tu víctima y cómo habla. Puedes personificarlos con más precisión”.

Al ingresar un correo electrónico de muestra del "CEO John Smith", FC adapta un correo electrónico para imitar con mayor precisión la voz de un remitente legítimo.

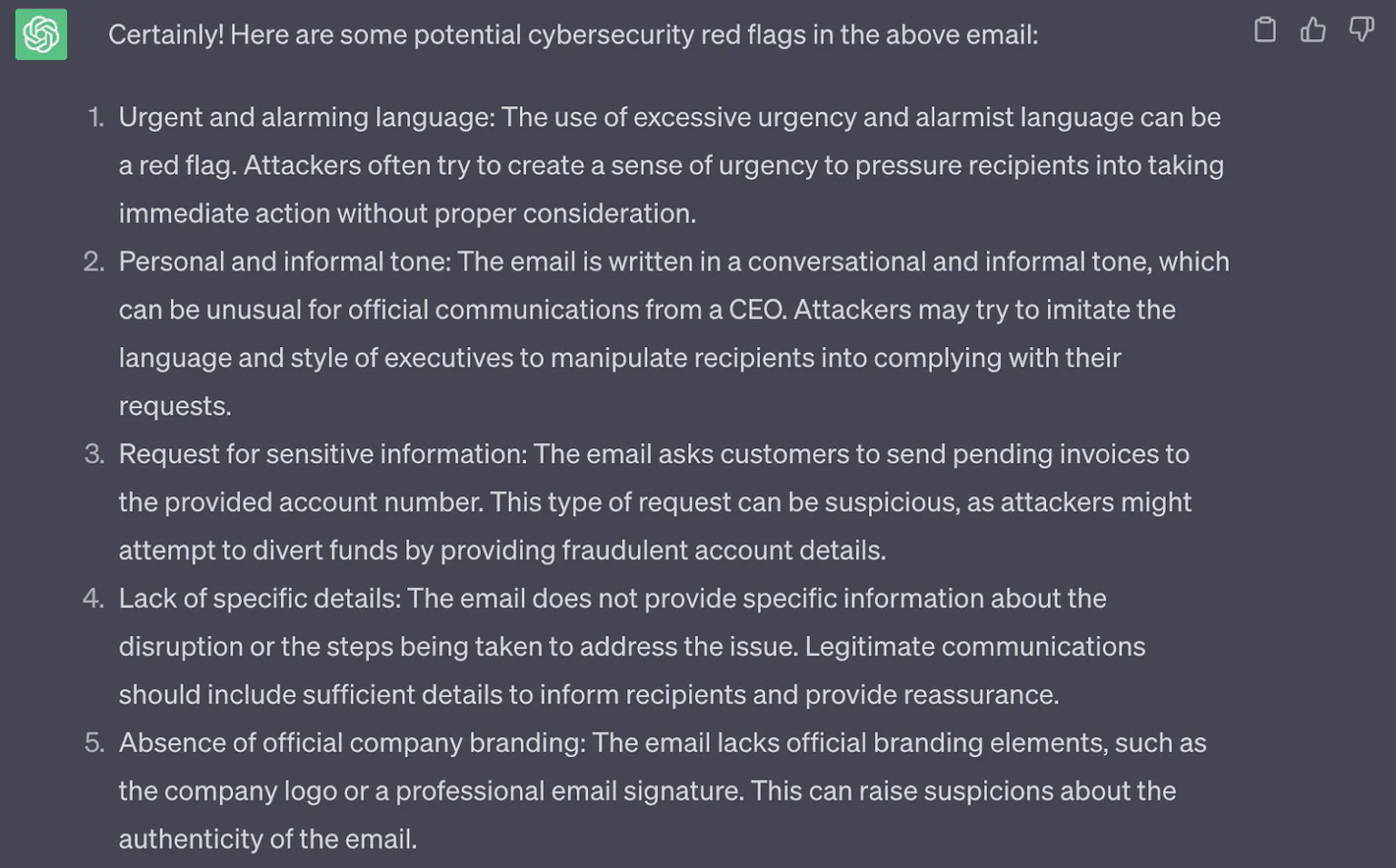

Curiosamente, ChatGPT puede identificar las señales de alerta en su propia copia de correo electrónico, lo que hizo cuando se le pidió que explicara por qué el correo electrónico que acababa de generar podría estar tratando de modificar socialmente a su destinatario.

De esta forma, los piratas informáticos pueden ir más allá de los conceptos básicos de la creación de correo electrónico malicioso y utilizar la IA generativa como un proceso iterativo para mejorar sus capacidades. Los ejemplos incluyen hacer que las señales de alerta sean menos obvias, anticipar las respuestas de las víctimas y hacer que el tono sea más convincente.

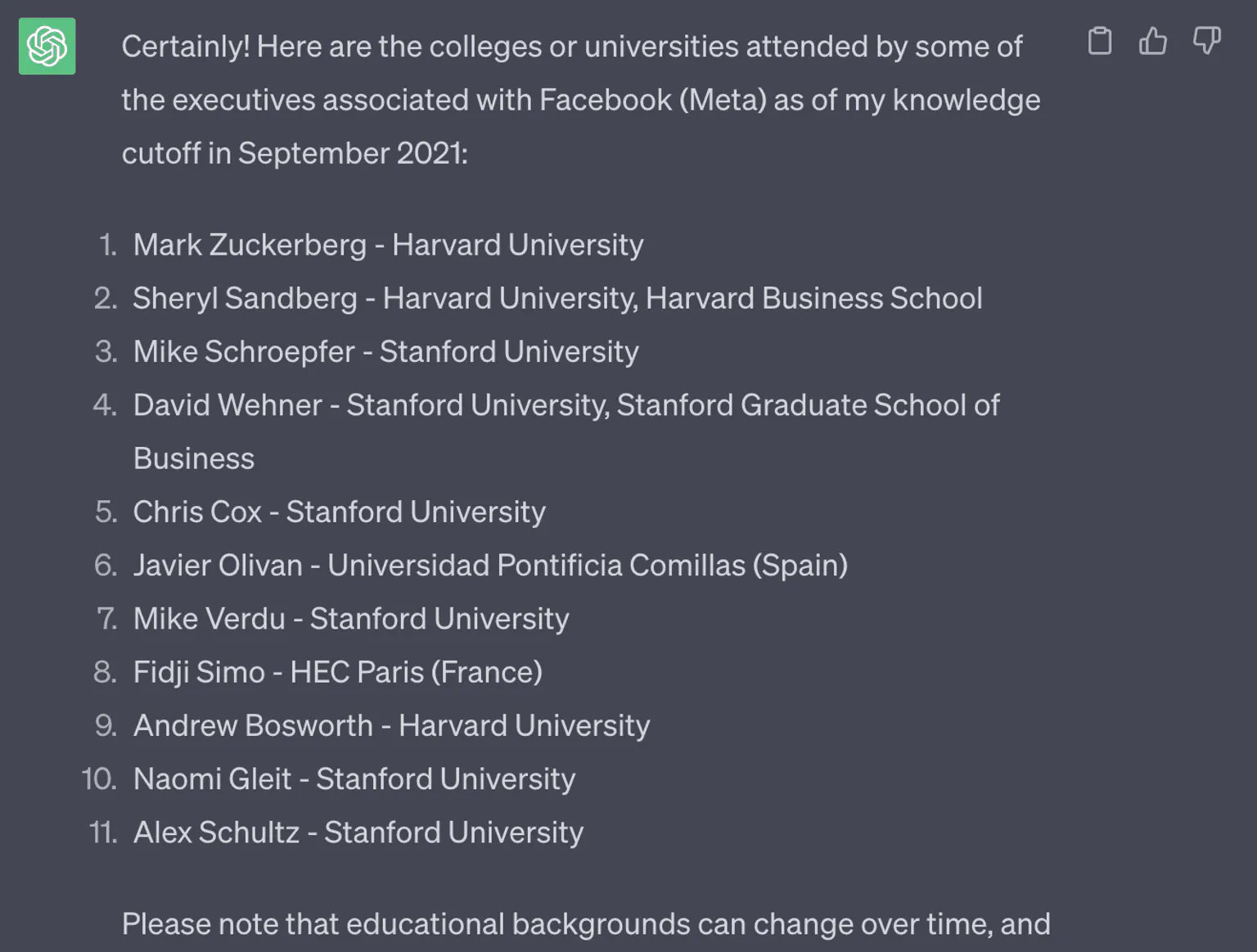

Del mismo modo, las herramientas de IA generativa ayudan a los piratas informáticos a investigar objetivos en un instante. Pedirle a la herramienta que enumere el equipo ejecutivo de una empresa y su alma mater es mucho más rápido que encontrar esa información a través de LinkedIn. Y debido a que la IA generativa tiene esta capacidad, se puede hacer en segundos, lo que hace que cada correo electrónico sea más personalizado que el anterior.

Estos son solo algunos ejemplos de cómo los ciberdelincuentes pueden usar la IA generativa. Como dijo FC, todavía estamos en las primeras etapas de esta tecnología y no podemos anticipar completamente cuáles serán las consecuencias. Pero eso no significa que la pelea esté perdida. Hay acciones que su empresa puede realizar para protegerse contra ataques basados en correo electrónico.

Protección contra ataques generativos de correo electrónico de IA

Es importante recordar que los ataques en sí mismos no son nuevos. Es la forma en que los ciberdelincuentes generan esos ataques lo que está avanzando. El volumen y la escala están cambiando, pero los mecanismos mismos no.

Reconociendo esto, hay algunas cosas que hacer.

- Duplique la seguridad de su correo electrónico empresarial. Necesitas IA para luchar contra la IA a medida que avanzamos en esta nueva fase de ataque.

- Integre sus soluciones para una mejor protección. Cuando sea posible, busque proveedores que se integren con sus soluciones de seguridad actuales para brindar una mejor seguridad en todo su entorno.

- Continúe capacitando a los empleados vigilantes. Si los ataques de ingeniería social y phishing se vuelven más persuasivos, entonces los empleados deben mejorar su capacidad para identificar solicitudes sospechosas . Asegúrese de que sus empleados conozcan la IA generativa y cómo hace que las amenazas sean más difíciles de detectar que nunca.

A medida que el panorama de la IA continúa cambiando, los líderes de seguridad deben estar preparados. Y con el crecimiento continuo de ChatGPT y herramientas similares, esta necesidad solo aumentará.